Suite du feuilleton inauguré la semaine dernière]. Après nous être intéressés aux origines Vichystes de notre système électrique, nous allons essayer cette semaine de démontrer ce qu’il se cache derrière l’imposition à tous les ménages de ces charmants compteurs électriques intelligents nommés Linky. Une machine de surveillance économique et la mise en oeuvre des théories économiques de Jean Tirole, notre prix Nobel d’économie.

Le génie électrique.

Épisode 2.

Les smart grids.

Que sont les Smart Grids, ces « réseaux intelligents » ?

Il s’agit d’un système constitué par des réseaux électriques auxquels se superposent des réseaux informatiques au moyen de la technique CPL (Courant Porteur de Ligne). C’est une fusion parfaite entre la technique et l’économique.

La finalité est d’intégrer les énergies renouvelables intermittentes (éolien et solaire photovoltaïque) et les nouveaux usages de l’électricité (voiture électrique) en limitant au maximum les investissements de renforcement des réseaux existants.

Nous sommes face à un problème typique de recherche opérationnelle (RO). C’est-à-dire un dérivé de ce qu’en économie, on nomme « planification ».

L’enjeu est d’optimiser au maximum les infrastructures existantes. Comme internet qui utilise le réseau téléphonique ou comme le TGV qui peut utiliser le réseau ferré ancien. On se souviendra au passage que si nous ne nous pouvons nous déplacer aujourd’hui à 600 km/h dans des trains retro-futuristes montés sur coussins d’air, c’est que la solution de l’aérotrain conçu dans les années 1960 était certes beaucoup plus “performante” techniquement que le TGV mais économiquement impossible par la lourdeur des investissements d’infrastructures nouvelles.

Les Smarts Grids répondent donc à cette nécessité d’optimisation du réseau électrique. Il s’agit, pour les distributeurs, de développer de « l’intelligence » sur le réseau existant. Pour cela, ils ont inventé et implémenté des capteurs, des compteurs communicants, une chaîne de transmission d’informations renforcée, des analyses instantanées « en temps réel » de divers paramètres techniques et économiques, des logiciels de décision et des automatismes télécommandés. L’usage, la distribution et le marché de l’électricité doivent être cybernétiquement planifiés. Ce qui nous est présenté comme la libéralisation d’un besoin – l’énergie – relève en réalité de la plus pure planification. C’est donc l’une des bases même de la théorie économique moderne qui s’envole en fumée : l’opposition plan-marché est une mystification. Les économistes sérieux le savent : il n’y a d’économie que capitaliste.

Quelles sont les fonctions des « Smart Grids ? »

ErDF, c’est l’URSS avec Iphone. Ses communicants savent convaincre. Les « réseaux intelligents » seraient d’abord la possibilité d’intégrer « massivement » les sources d’énergie renouvelables. On sait pourtant que cela représente une part très faible de la production globale et que cela sera toujours plus « massivement » marginale avec le développement du gaz de schiste aux Etats-Unis.

Mais nous sommes en France, et s’il y a bien une chose que nous aimons et chérissons, c’est notre industrie automobile. Et le gouvernement favorise la conversion vers le tout électrique, contrairement à l’hybride japonais, par exemple. L’une des fonctions des « Réseaux Intelligents », c’est de contribuer au développement des véhicules électriques et de leurs infrastructures de chargement.

C’est le point central : établir de nouveaux marchés ou de nouveaux mécanismes de marché.

L’une des tâches de ces « réseaux intelligents » est de mettre en place des leviers économiques qui permettent d’optimiser l’exploitation du réseau et par exemple de donner la priorité au chargement des voitures électriques. Écrêtement, effacement, délestages de la consommation des « clients » sans que ceux-ci ne soient consultés. Les projections de consommation impliquent des charges accrues. Comme il n’est pas question de développer un nouveau réseau, sauf localement (nous retrouvons le cas d’internet ou du TGV), il devient nécessaire d’avoir une « gestion dynamique », par des leviers économiques, du réseau existant soumis à des contraintes de limite.

Ces leviers économiques sont introduits par la loi BROTTES [1] du 15 avril 2013. Loi 2013-312 visant à préparer la transition vers un système énergétique sobreet portant dispositions sur la tarification.

Pour comprendre l’enjeu, il suffit de se pencher sur le Titre I de la loi. Il établissait un “Bonus-Malus sur les consommations domestiques d’énergie” mais a été censuré par le Conseil Constitutionnel. Il était effectivement difficile de justifier les différences de tarifs – les pauvres devant plus payer, parce qu’incapables de financer les opérations de transition les concernant, comme l’achat de systèmes de chauffage sobres, pompes à chaleur ou autres. Notons ici que tous les “systèmes sobres” consomment de l’électricité, mais que l’électricité, globalement nucléaire, est considéré comme irrévocablement « propre ».

L’article 14 est lui aussi particulièrement intéressant. Il porte sur l’effacement de la consommation d’électricité et la contribution des opérateurs d’effacement [2] aux objectifs de la politique énergétique.

Les opérateurs de distribution (RTE, ERDF, etc.), DSO (distribution system operators), sont placés au centre de ces systèmes « intelligents » Les DSO doivent rendre leurs réseaux plus actifs et plus réactifs, proactifs, pour obtenir un pilotage dynamique.

Les « Smart Grids » doivent permettre la gestion dynamique du réseau à l’aide de modèles de programmation tout aussi dynamiques.

Cette gestion dynamique va utiliser des capteurs (les « compteurs intelligents ») et des dispositifs de communication pour transférer en temps réel les informations de gestion vers les centres de pilotage (ce que l’on nomme planification décentralisée, two levels planning).

Les projets pour les « Réseaux Intelligents » ou les analyses fonctionnelles de ces Smart Grids ont été réalisés par des organismes européens, tels que la Task Force for Smart Grids de la Commission ou des services des opérateurs DSO eux-mêmes.

La Commission Européenne décrit parfaitement les fonctions des Smart Grids comme des fonctions de planification au moyen de « néomarchés intégrés ». C’est l’application des « marchés biface » de notre prix Nobel d’économie : Jean Tirole.

Le déploiement des capteurs, des compteurs intelligents, tient une place essentielle dans cette planification : celle de la collecte des données et de leur analyse afin de permettre des interventions instantanées. Les compteurs intelligents doivent permettre de préprogrammer automatiquement l’ « effacement » de la consommation. Ce qui consiste, « en cas de déséquilibre offre/demande d’électricité à provisoirement (en période de pointe journalière et/ou saisonnière de consommation électrique) réduire la consommation physique d’un site donné ou d’un groupe d’acteurs (par rapport à sa consommation « normale »), l’effacement étant déclenché par une stimulation extérieure. »

Les consommateurs sont étudiés et suivis afin que le profil de leur consommation soit « guidées » et redressées afin de s’accorder aux nécessités générales du réseau.

Ce système de pilotage des actions, comme tout système de planification ou de marché, opère au moyen de pénalités financières : c’est ce que permet le système de Bonus-Malus de la loi Brottes et la stratification de la loi NOME (Nouvelle Organisation du Marché de l’Électricité)

Loi 2010-1488 du 7 décembre 2010.

Ce que supervisent les « réseaux intelligents » ce sont les comportements. Il s’agit de contrôler la demande, ce maillon faible de toute planification économique.

Il va de soi que pour ces systèmes de transferts d’informations vers les centres opérationnels des DSO (Opérateurs de distribution), il n’est pas question de réciprocité : l’information ne va que dans un sens. Les instructions comme les procédures d’effacement, sont sans consultations du client.

Du reste, la montée en puissance des capteurs intelligents et des systèmes de comptage est une priorité européenne.

Cette priorité se concrétise par le troisième paquet énergie (directive relative aux services énergétiques). Selon cette directive, à transcrire nationalement, il sera exigé que les consommateurs soient équipés des compteurs (très) intelligents. Ces compteurs seront rendus obligatoires et imposés.

En effet, ces compteurs sont indispensables pour permettre aux néomarchés de l’énergie de fonctionner correctement.

Ils permettent d’augmenter la capacité à agir à distance, d’améliorer l’analyse économique et la prévision, d’obtenir de meilleurs capacités d’observation et de contrôle. Un rêve soviétique.

[3]

À quoi et à qui sert votre compteur LINKY ?

Le projet Linky est un projet optimisé en stricte cohérence avec l’architecture économique des réseaux.

Il se limite ainsi aux composants de communication compris entre le compteur (le périphérique) et le système central de gestion (le centre de planification).

Le système Linky comprend trois niveaux :

(a) Un système central d’orchestration programmation et de supervision ;

(b) Un système décentralisé, le compteur et son logiciel, le concentrateur et ses logiciels (la partie “décentralisée” est donc pilotée à distance) ;

(c) Un centre d’opération (NOC, Network Operation Center) qui assure la cohésion entre le centre de supervision et ses périphériques.

Tout cela pouvant être quasiment automatisé.

Le choix d’ERDF s’est porté sur la technique CPL [4] de communication, bande CENELEC A, 5 à 95 KHz. Permettant l’utilisation des modems les plus performants.

Notons que cette bande de fréquence est réservée aux DSO.

Nous avons un système de gestion centralisé au moyen d’une mesure automatique.

Ce système de gestion est mis en place au moyen d’un système tarifaire nommé TURPE, tarif d’utilisation des réseaux publics d’électricité.

L’un des éléments centraux de cette planification dite décentralisée est la technique CPL G3.

La communication CPL s’appuie sur un signal de plus haute fréquence et de plus faible énergie qui se superpose au courant électrique.

La communication CPL peut utiliser directement les réseaux de moyenne et basse tension comme des supports de transmission.

Pour la haute tension, il faut déployer un réseau parallèle.

Le signal CPL permet de transmettre toutes les informations utiles au DSO et sur l’ensemble du réseau.

Comme la qualité des câbles affecte la qualité de la communication CPL, une nouvelle technique CPL G3, insensible au câblage et donc performante et sûre quel que soit l’environnement matériel, a été mise au point et s’impose comme nouvelle norme.

Le système Linky de mesure et de contrôle est au service exclusif des DSO.

Permettant, par exemple, d’améliorer les décisions d’investissement.

Mais plus fondamentalement, le système Linky est une pièce indispensable du marché de l’électricité.

En particulier du Two Sided Market, développé par l’École de Toulouse [5].

Les Smart Grids, Linky et le marché.

Qu’est-ce que le « marché bi-face » développé par Jean Tirole, prix Nobel de la Toulouse School of Economics ?

Ce « Two-sided market » repose sur le développement de propositions de services différents à plusieurs parties et sur la valorisation des externalités positives existant entre chacune des parties. Le service proposé par l’une des parties prenantes est l’occasion de valoriser des données comportementales auprès d’une autre partie. La surveillance, devient profitable.

Si vous n’avez pas compris, prenons un exemple.

Vous êtes une plate-forme de paiement par carte bancaire [6], non seulement vous allez devenir riche en proposant votre service premier mais dans un second temps, votre support d’enregistrement des transactions va être l’occasion de constituer une source de données comportementales de vos clients qu’il vous suffira de revendre à d’autres acteurs. Le « marché bi-face » c’est lorsqu’on gagne deux fois.

Reprenons notre innocent compteur Linky. Non seulement, il a un usage interne pour ceux qui nous vendent l’électricité mais il est aussi le moyen d’une valorisation extérieure. Les milliards de données quant à la consommation et au comportement énergétique de millions de ménages, ne vont pas avoir trop de mal à trouver des acheteurs. Quelle assurance ne serait pas prête à payer pour connaître la fréquentation des domiciles de ces prestataires. [7]

Le champ de ces services se nomme : smart building. Il s’agit d’ « engager » et de contraindre de manière active les clients. C’est le système des « incitations » dont notre économiste national est le spécialiste. [8]

Pourquoi les « réseaux intelligents » sont la pointe avancée de l’économie néoclassique ?

Repartons directement du débat sur la planification par le marché. La théorie économique voudrait que contrôle et marché soient deux rationalités distinctes mais surtout contradictoires car ennemies. Soit on contrôle et planifie, soit on laisse le marché s’auto-réguler. La NEP ou la main invisible, il faut choisir son équipe.

Les ingénieurs d’ErDF auraient-ils inventé une synthèse des deux courants présentés comme ennemis de l’économie ? Non, d’autres y avaient réfléchi avant eux.

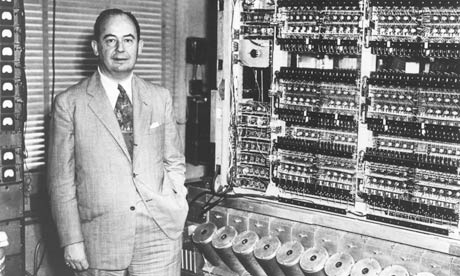

Intéressons-nous à John Von Neumann, l’un des pères de la cybernétique.

Pour comprendre ce qui se cache derrière votre compteur Linky, il faut comprendre les théories de Von Neumann et le pont qu’elles dessinent des théories économiques néoclassiques jusqu’aux « réseaux intelligents ».

Il y a quatre constructions de von Neumann qui ont été liées :

La calculabilité économique effective et donc la planification effective ;

La théorie des automates qui est une théorie des marchés mobilisés par la planification ;

L’architecture des calculateurs (ou ordinateurs) établie pour permettre la résolution du problème (gigantesque) du calcul des prix ;

La théorie des jeux, qui est en fait une méthode de résolution du problème de l’équilibre (de l’optimisation).

Du point de vue de von Neumann la cybernétique est identique à l’économique.

C’est ce point de vue qui triomphe pour les néoclassiques américains d’après-guerre.

Centrons-nous sur la théorie des automates(de von Neumann dont nous avons dit qu’il s’agissait d’une théorie des marchés calculables.

La théorie des automates se présente comme l’analyse d’un processus liant des entités abstraites au moyen de flux d’informations. Ce processus est conçu comme étant auto-régulateur et en interaction avec son environnement.

Quels sont les présupposés nécessaires pour que l’automate soit auto-régulateur ?

Les mêmes hypothèses que celles nécessaires pour le développement d’une architecture d’un calculateur digital.

Quels sont les présupposés nécessaires pour qu’un tel automate puisse se redupliquer de lui-même et avec le même niveau de complexité ?

Il faut que l’automate soit un automate probabiliste. Ce qui renvoie à la théorie des jeux.

Existe-t-il un automate universel qui peut reconstruire tout autre automate ?

Oui, une machine de Turing modifiée.

Peut-on définir des régularités pour les méthodes de résistance à la dégradation entropique (au bruit) lors de l’auto-reproduction ?

Quelles sont les conditions de l’évolution d’un automate vers un automate de plus grande complexité opérationnelle ?

Qu’est-ce que la mesure de la complexité ?

Toutes ces questions et les réponses que von Neumann y apporte sont à la source d’une théorie complète du marché comme automate programmable.

La science informatique du calcul machinique permet la planification par le marché programmable. Cette techno-science a été structurée autour d’une hiérarchie évolutive d’automates (de marchés) de plus en plus puissants en termes de capacité de calcul.

Le marché machine est d’abord une machine à effectuer des calculs, soit dire l’analogue d’un computer.

La théorie de von Neumann de l’économie calculable ou de la planification effective est subordonnée à l’analyse formelle des capacités “psychologiques” de l’agent économique défini comme pièce (appareil de mesure) d’un calculateur (le marché), est subordonnée à l’analyse formelle du marché comme MACHINE fonctionnant sur la base d’agents réduits à être des CAPTEURS ou des compteurs ou des instruments de mesure.

Tous les objets de la théorie des automates (formant l’économie calculable planifiable) répondent à la question de la valeur : pourquoi l’économie est-elle quantitative ?

Surtout lorsque l’on envisage la capacité mathématique limitée des agents de base (mais remplacés par des capteurs ou des instruments de mesure pilotés à distance).

Ou, comment sur la base d’une population inapte au calcul peut se développer un énorme système calculatoire opérationnel ?

La réponse de von Neumann est que des institutions économiques obligatoires seules permettent de répondre à la question de la calculabilité.

Von Neumann dévoile l’aspect autoritaire de l’économie. Mais, également, peut être considéré comme un adepte de « l’ordo-libéralisme » (forme germanique du néolibéralisme).

Ces fameuses institutions enforcées, rendues obligatoires (comme les néomarchés et leurs appareillages – Linky doit être obligatoire), ont une fonction algorithmique de mesure, de calcul, d’opérations.

C’est pourquoi le marché construit et imposé doit être pensé comme une machine à calculer qui pallie les déficiences humaines.

Les marchés sont des PROTHÈSES machiniques.

Et ces prothèses ont la capacité de se reproduire (auto-régulation, flexibilité) et d’évoluer vers des formes plus complexes.

C’est la vision néoclassique du système économique envisagé comme une gigantesque machinerie.

Une machine à calculer qui, sans arrêt, génère les solutions opérationnelles d’un flux sans fin de problèmes quantitatifs.

Les marchés étant des machines opérationnelles, on peut en effectuer une classification en fonction de leurs procédures algorithmiques.

Dans cette approche, il est possible de définir complétement les marchés par leurs capacités de calcul ou par leur complexité.

C’est à partir de là que se développe l’analyse de la TSE, dont nous avons rencontré un exemple.

Le noyau du programme néoclassique est qu’il est possible de définir l’économie comme un supercalculateur programmable.

Et que cette programmation nécessite de discipliner les sujets pour qu’ils agissent comme des calculateurs (des lignes de programmes). Le système des marchés est un système disciplinaire et un système de communication pour lequel l’information codée sous forme de valeur ou de prix est transmise à tous les agents qui ne peuvent agir qu’en fonction de cette information codée.

Tout autre comportement que celui du calcul est déviant.